Les Transformers sont des modèles de traitement du langage avancés utilisés pour analyser et générer du texte ou des images.

Depuis leur invention en 2017, ils ont révolutionné le traitement automatique des langues et la vision par ordinateur, offrant une grande précision dans des applications telles que la traduction automatique et la reconnaissance d’images.

Origine du mot Transformer

Le terme Transformer vient de l’anglais et signifie « modifier » ou « changer ». Cette architecture a été introduite pour la première fois dans l’article scientifique « Attention is All You Need », publié en 2017 par une équipe de chercheurs spécialisés en intelligence artificielle.

Pourquoi les Transformers sont-ils si puissants ?

Avant les Transformers, les ordinateurs utilisaient des modèles séquentiels comme les réseaux de neurones récurrents (RNN). Ces systèmes étaient plus lents et moins efficaces pour traiter de longues séquences de texte.

Les Transformers permettent d’analyser simultanément toutes les parties d’un texte, améliorant ainsi la vitesse et la précision. Ils sont particulièrement efficaces pour :

- La traduction automatique de textes en plusieurs langues.

- La génération de contenus écrits (ex. : résumés, réponses à des questions).

- La reconnaissance d’objets et de visages sur des images.

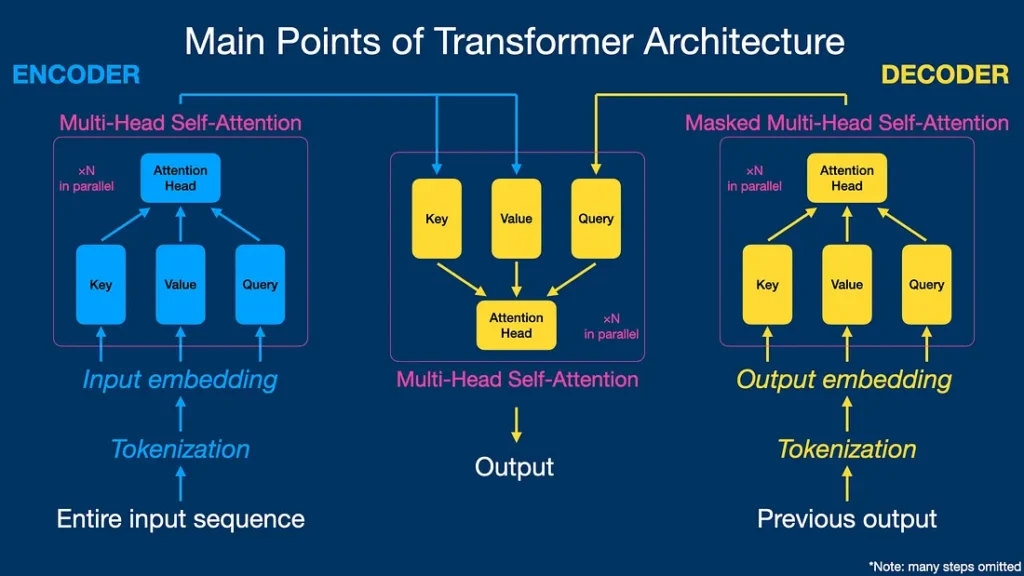

Structure et fonctionnement d’un Transformer

Source : https://medium.com

L’architecture Transformer repose sur plusieurs éléments fondamentaux :

- Encodage et Décodage :

- L’encodeur transforme le texte ou l’image en une série de valeurs numériques compréhensibles par l’ordinateur.

- Le décodeur utilise ces valeurs pour générer un résultat, comme une traduction ou une prédiction.

- Mécanisme d’attention :

- Le modèle analyse chaque mot d’une phrase et calcule son importance par rapport aux autres mots pour en comprendre le sens global.

- Multi-attention :

- Plusieurs mécanismes d’attention fonctionnent en parallèle pour mieux comprendre les relations entre les mots sous différents angles.

- Encodage de position :

- Les Transformers ajoutent des informations de position pour conserver la structure de la phrase.

- Couches successives :

- Plusieurs couches permettent d’affiner la compréhension du texte à chaque étape.

Pour compléter, voici un document de Vincent Binet qui résume l’origine et le fonctionnement simplifié de l’architecture Transformer :

Variantes de l’architecture Transformer

Depuis leur création, plusieurs variantes du Transformer ont vu le jour, notamment :

- BERT (Bidirectional Encoder Representations from Transformers) : capable d’analyser un texte dans les deux sens pour mieux comprendre son contexte. Cette technologie est notamment exploitée par Google pour fournir des réponses pertinentes à l’utilisateur.

- GPT (Generative Pre-trained Transformer) : spécialisé dans la génération de textes fluides et cohérents. Ce terme est aujourd’hui bien connu du grand public grâce à l’outil ChatGPT.

- ViT (Vision Transformer) : appliqué à la reconnaissance et à l’analyse d’images.

Applications pratiques des Transformers

L’architecture Transformers est aujourd’hui largement utilisée dans différents domaines, tels que :

- Traitement automatique du langage (NLP) : traduction, génération de texte, analyse des sentiments.

- Vision par ordinateur : identification d’objets, amélioration de la qualité des images.

- Santé : diagnostic médical basé sur des images. Un exemple concret est l’assistance pour les radiologues.

- Commerce : recommandations personnalisées pour les clients. Ce qui améliore l’efficacité des sites e-commerce, par exemple.

Avantages et limites des Transformers

Avantages :

- Traitement rapide et précis de grandes quantités de données.

- Capacité à comprendre des relations complexes dans les textes.

- Polyvalence et adaptation à divers types de données.

Limites :

- Exigent des ressources techniques considérables.

- Mise en œuvre et entraînement complexes.

- Dépendance importante à la qualité et à la quantité des données d’entraînement.

Ce qu’il faut retenir

Les Transformers ont véritablement « transformé » le domaine de l’intelligence artificielle !

Grâce à des mécanismes fonctionnant en parallèle, les Transformers ont décuplé la vitesse et la précision des modèles d’IA.

Sans cette évolution, ChatGPT n’aurait pas vu le jour.

Les chercheurs en IA travaillent à repousser les limites actuelles de l’architecture Transformers pour atteindre des performances encore plus élevées.