L’intelligence artificielle entre dans le quotidien des individus à une vitesse fulgurante.

Des chatbots simples aux agents IA complexes, cette technologie se diffuse massivement. Mais cela n’est pas sans risques.

Face à cette évolution, l’Union européenne a pris les devants en proposant un cadre réglementaire ambitieux : l’AI Act. Ce texte vise à garantir que l’IA utilisée et développée en Europe respecte les droits fondamentaux et les valeurs européennes.

Explication détaillée

L’AI Act (ou Règlement sur l’intelligence artificielle) est la première tentative au monde de créer une loi exhaustive régulant l’IA.

Proposé par la Commission européenne en avril 2021, ce règlement a pour objectif principal de créer un écosystème d’IA fiable et sûr en Europe. Tout en encourageant l’innovation.

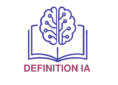

Il s’appuie sur une approche basée sur le risque : plus un système d’IA présente un risque élevé pour la sécurité ou les droits fondamentaux des individus, plus les exigences réglementaires sont strictes.

Pour consulter le détail de cette règlementation, cliquez sur ce lien.

Quels problèmes soulèvent l’usage inapproprié de l’IA ?

Le développement rapide de l’IA soulève de nombreuses questions d’alignement et de sécurité. Sans cadre réglementaire, les outils d’IA pourraient potentiellement :

- Discriminer certains groupes de personnes (par exemple, lors de recrutements).

- Mener à des décisions non alignées sur les valeurs éthiques.

- Porter atteinte à la vie privée et à la sécurité des données des individus.

- Être utilisés à des fins de surveillance de masse ou de désinformation.

- Présenter des risques pour la sécurité physique dans des domaines critiques (par exemple, pour les véhicules autonomes ou les dispositifs médicaux).

L’AI Act vise à prévenir ces dérives en établissant des règles claires pour les concepteurs et les utilisateurs de modèles d’IA.

Les catégories de risques de l’AI Act

L’IA est un domaine vaste et complexe. Cela parait difficile de mettre en place un cadre juridique précis sur ce domaine.

La loi érige le principe de classification des risques pour présenter un cadre réglementaire.

1. Risque Inacceptable

Certains systèmes d’IA sont jugés non conformes aux valeurs de l’UE pour être autorisés. Il s’agit notamment d’outils qui :

- Utilisent des procédés de surveillance sociale par les gouvernements.

- Permettent de faire de la discrimination contre certains groupes sociaux.

- Recueillent l’identité biométrique à distance en temps réel dans les espaces publics à des fins répressives (avec des exceptions très strictes).

Ces systèmes seront en théorie interdits.

2. Risque Élevé

Cette catégorie concerne les modèles d’IA qui présentent un risque significatif pour la santé, la sécurité ou les droits individuels. Cela inclut, entre autres :

- Les outils d’IA utilisés dans des infrastructures critiques (eau, gaz, électricité).

- Ceux utilisés dans les dispositifs et diagnostics médicaux.

- Les systèmes d’IA pour l’évaluation ou le recrutement de collaborateurs sur des critères biaisés (comme l’âge).

- Les modèles d’IA utilisés pour l’étude de la solvabilité ou l’accès aux services publics.

- Les systèmes d’IA dans le domaine judiciaire (par exemple, évaluation des risques de récidive pour un détenu).

Les outils d’IA à haut risque devront se conformer à des exigences strictes avant d’être mis sur le marché, telles que :

- Mise en place de systèmes de gestion des risques.

- Qualité des données robuste.

- Documentation détaillée et transparence.

- Supervision humaine.

- Audit.

3. Risque Limité (Transparence)

Cette catégorie inclut les systèmes d’IA qui posent des risques spécifiques en termes de transparence.

C’est le cas du contenu réalisé ou modifié grâce à l’intelligence artificielle (deepfake). L’exigence principale est que les utilisateurs soient informés qu’ils interagissent avec une IA ou que le contenu a été généré par l’Intelligence artificielle.

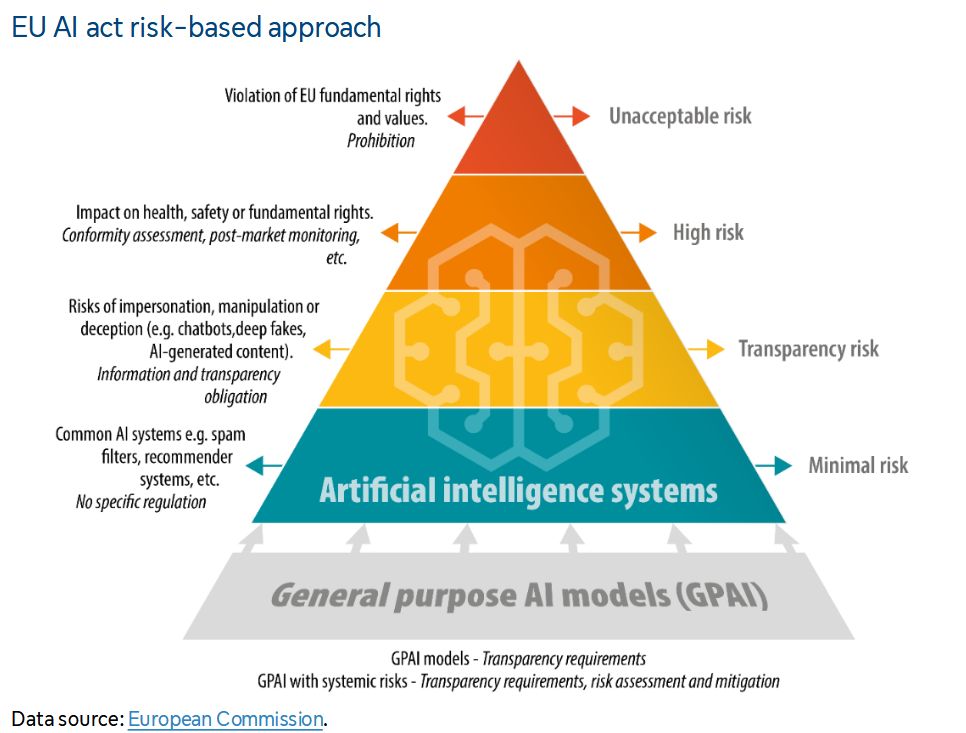

LinkedIn, par exemple, affiche une indication issue du C2PA lorsqu’une image est générée par l’IA.

Exemple de visuel avec une indication de l’usage de l’IA sur LinkedIn

Coalition for Content Provenance and Authenticity (C2PA) est une initiative de plusieurs acteurs (notamment Adobe, Intel, Microsoft). Elle développe des standards pour certifier la source et l’historique du contenu média numérique.

4. Risque minimal

Cela concerne les systèmes d’IA utilisés dans des cas courants, à faible impact. Par exemple, les outils de recommandation en e-commerce ou les filtres anti-spam.

Ils ne sont pas soumis à des obligations spécifiques de l’IA Act. Néanmoins, les concepteurs sont encouragés à adopter des codes de conduite éthiques.

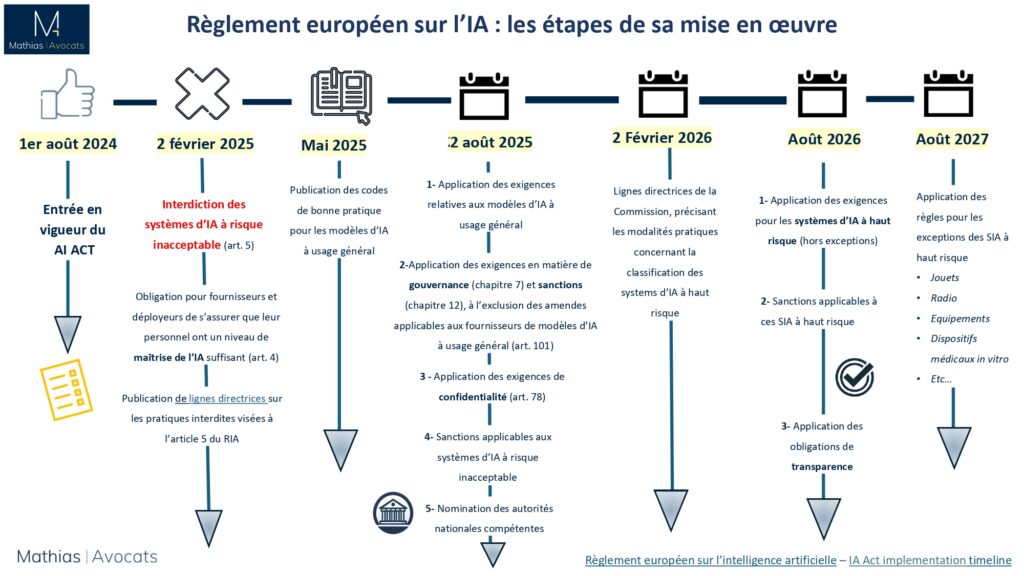

Calendrier prévisionnel de mise en place de l’AI Act

Pour des raisons évidentes de mise en conformité, les dispositions de l’AI Act seront imposées progressivement.

Voici un calendrier proposé par le cabinet Mathias Avocats pour y voir plus clair :

AI Act : peut-il vraiment s’appliquer ?

L’IA Act n’est pas seulement un ensemble de règles ; c’est une déclaration de principes sur la manière dont nous souhaitons que l’IA se développe.

Il s’agit de s’assurer que cette technologie disruptive serve l’humanité de manière éthique, responsable et sûre.

Mais au-delà de cette déclaration de principes, sa mise en œuvre se heurte à des écueils importants.

Les États-Unis sont les fournisseurs principaux des solutions d’IA générative : ChatGPT, Gemini…

Et ces derniers n’ont pas adopté, à date, de réglementation similaire.

La question de la transparence est notamment problématique. Car les acteurs dominants de l’IA sont des entités privées.

Ils veillent à garder le fonctionnement précis de leurs outils secret face à la menace des concurrents.

Un autre élément soulève question : On imagine mal une organisation indiquer publiquement qu’elle va utiliser l’IA pour surveiller les citoyens…

Pourtant, les gouvernements risquent d’invoquer des raisons de « sécurité nationale » pour le faire, en toute discrétion.

L’IA n’est pas seulement une technologie, c’est une arme géopolitique. On vous conseille la lecture de Hyperarme de Flavien Chervet pour approfondir la réflexion.

L’AI Act a au moins le mérite de poser les bases de la réflexion sur les enjeux et risques liés à l’intelligence artificielle.

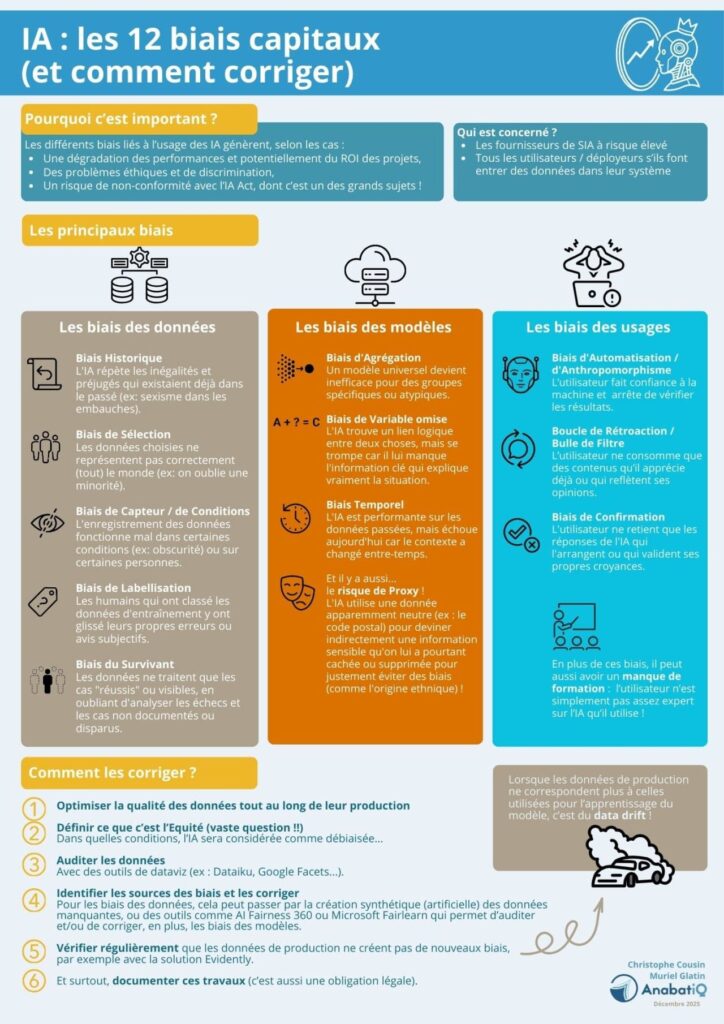

En complément, voici une infographie mettant en avant les biais cognitifs. Au-delà de leur nocivité pour les utilisateurs, les biais cognitifs augmentent les risques de non-conformité des outils à l’AI Act.