Étymologie

Les réseaux de neurones artificiels (RNA) tirent leur nom des neurones biologiques, qui sont les cellules de base du cerveau humain.

- « Neurones » : fait référence aux unités de traitement individuelles.

- « Artificiels » : met en avant leur caractère synthétique et mathématique.

Contexte et Historique

L’idée des RNA remonte aux années 1940, avec le modèle de McCulloch et Pitts, qui proposaient une abstraction mathématique des neurones biologiques.

Ensuite, en 1958, Frank Rosenblatt a introduit le perceptron, une des premières architectures fonctionnelles. Après un ralentissement dans les années 1970 (également appelé « l’hiver de l’IA »), les RNA ont connu un regain d’intérêt grâce aux avancées technologiques (augmentation de la puissance de calcul, développement d’algorithmes efficaces) et à l’essor du deep learning dans les années 2010.

Structure et Fonctionnement

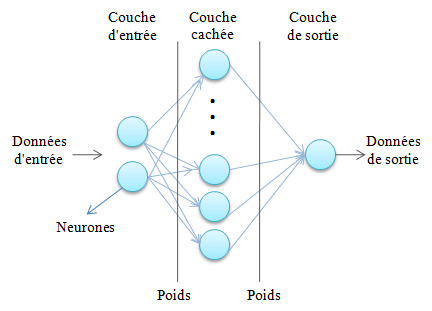

Les réseaux de neurones artificiels sont des modèles mathématiques conçus pour traiter et analyser des données complexes. Ils se composent de « neurones » artificiels organisés en couches interconnectées. (Source du visuel : researchgate.net).

- Couche d’entrée : Reçoit les données brutes.

- Couches cachées : Effectuent les traitements intermédiaires en appliquant des opérations comme la pondération et l’activation.

- Couche de sortie : Fournit les résultats finaux, tels qu’une classification ou une prédiction.

Chaque neurone exécute trois étapes principales :

- Réception des entrées : Les valeurs d’entrée sont multipliées par des poids spécifiques.

- Somme pondérée : Les valeurs sont additionnées pour produire un résultat intermédiaire.

- Activation : Une fonction non linéaire (par exemple, ReLU ou sigmoïde) transforme cette somme en une sortie utilisable.

L’apprentissage s’effectue grâce à des algorithmes comme la rétropropagation. Ces derniers ajustent les poids en fonction des erreurs calculées entre la sortie prédite et le résultat attendu.

Pour un débutant en IA, ce concept apparait complexe… Voici une vidéo qui explique le concept des neurones artificiels de façon pédagogique (doublée en français) :

Source : Chaine YouTube « 3Blue1Brown »

Variantes et Architectures

Plusieurs types de RNA sont adaptés à des problématiques variées :

- Perceptron : Modèle simple pour des problèmes linéaires.

- Réseaux de neurones convolutifs (CNN) : Idéaux pour le traitement des images.

- Réseaux de neurones récurrents (RNN) : Conçus pour traiter des données séquentielles, comme les séries temporelles ou les textes.

- Transformers : Utilisés pour des tâches complexes de traitement du langage naturel (NLP).

Applications Pratiques

Les RNA sont omniprésents dans de nombreux domaines :

- Vision par ordinateur : Reconnaissance faciale, détection d’objets.

- Traitement du langage naturel (NLP) : Traduction automatique, analyse de sentiment.

- Santé : Aide au diagnostic médical.

- Finance : Détection des fraudes, par exemple.

- Jeux : Stratégies basées sur l’IA (par exemple, AlphaGo).

Avantages et limites

Avantages :

- Flexibilité : Capacité à traiter des données variées et complexes.

- Performance : Précision exceptionnelle dans des contextes bien définis.

- Auto-apprentissage : Ajustement à des nouvelles données via l’entraînement.

Limites :

- Dépendance aux données : Nécessité de grands ensembles de données annotées.

- Coûts : Consommation importante de ressources en calcul et énergie.

- Manque de transparence : Difficile d’expliquer clairement les décisions (également appelé « effet de boîte noire »).

Ce qu’il faut retenir

Les réseaux de neurones artificiels sont une avancée majeure de l’intelligence artificielle. Leur capacité à résoudre des problèmes complexes dans divers domaines en fait un outil incontournable.

Toutefois, leur utilisation exige des ressources importantes et soulève des questions sur l’explicabilité de leurs décisions (effet boite noire).